Transformer介绍#

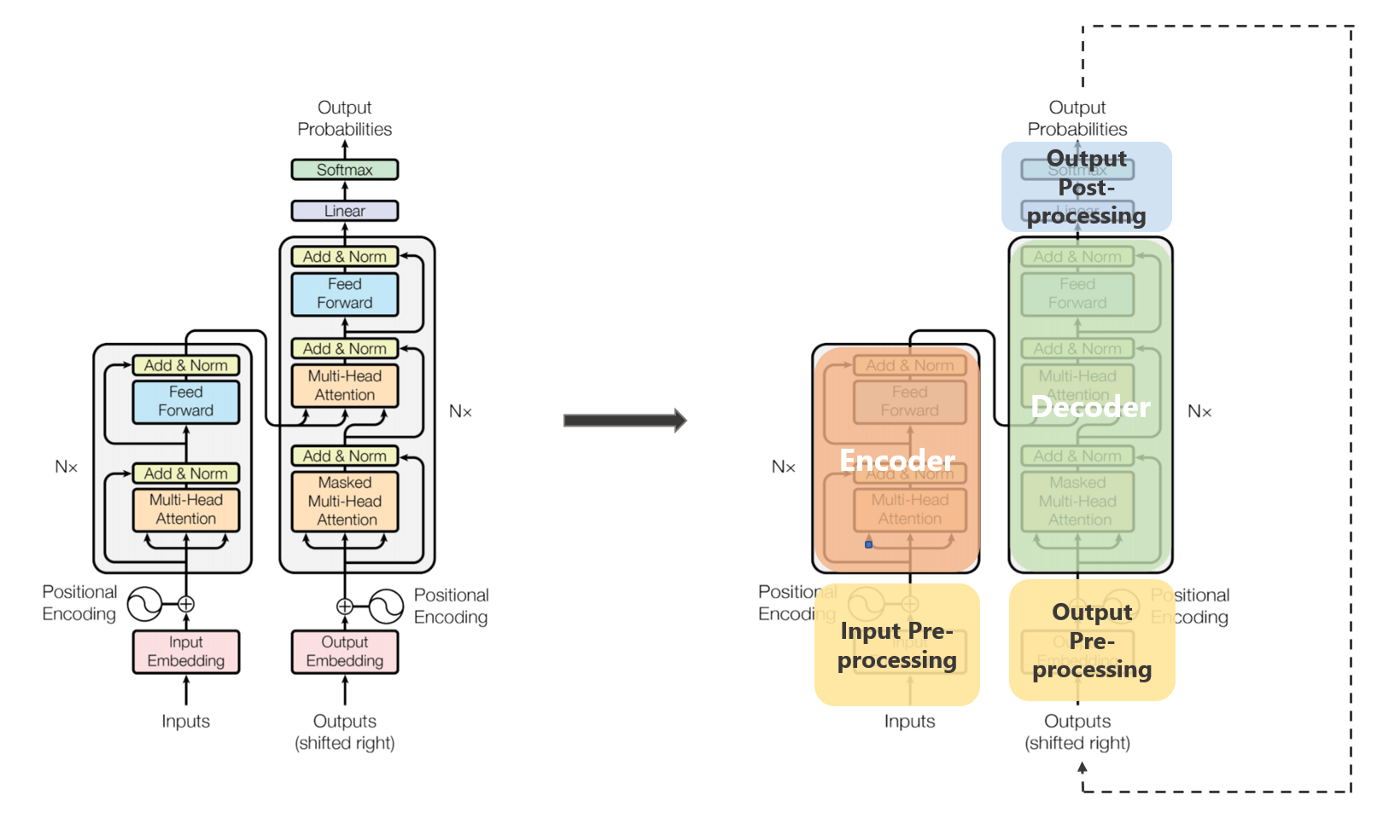

transformer的结构如下:

模型的主结构:

模型的输入和输出

输入:Inputs和Outputs(shifted right)

输出:Output Probabilities

位置编码:Positional Encoding

编码器和解码器*N

多头注意力机制:Multi-Head Attention 和Masked Multi-Head Attention

模型的子结构

词向量:Input Embedding和Output Embedding

前馈神经网络:Feed Forward

残差连接和层标准化:Add & Norm

线性层:Linear

softmax层

下面是来自沐神的图

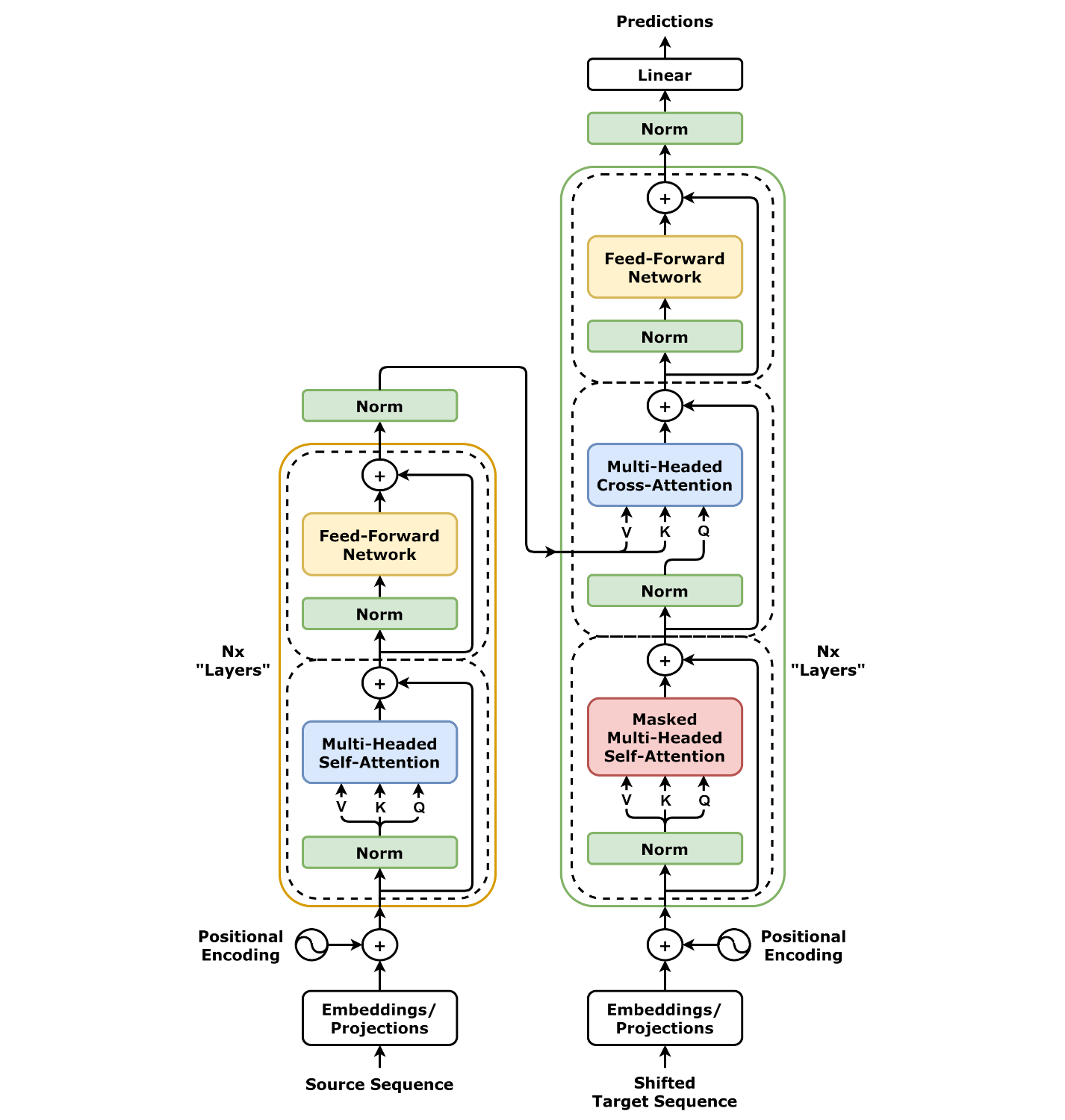

还有dvgodoy的图